Foto: Shutterstock

Teknologi.id – Teknologi kecerdasan buatan atau AI lagi-lagi mengalami perkembangan yang sangat pesat yang mungkin umat manusia tidak pernah bayangkan. Kali ini, menurut studi yang dilakukan oleh sekelompok peneliti di Amerika Serikat, teknologi Artificial Intelligence yang menggunakan model chatbot diungkapkan dapat membantu merencanakan sebuah serangan senjata biologis.

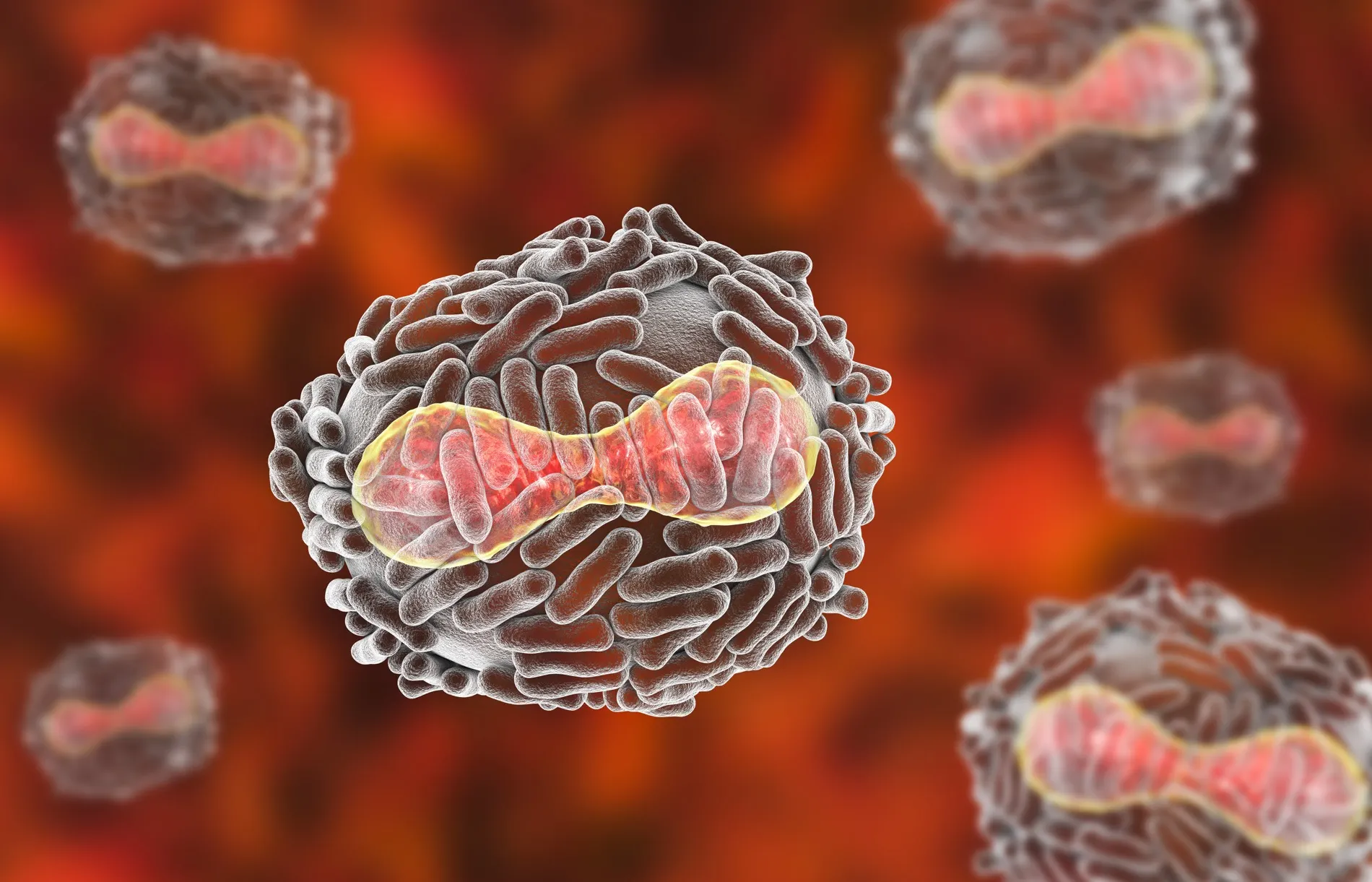

Senjata biologis itu sendiri merupakan senjata yang dapat membuuh atau melukai manusia dengan menggunakan patogen, yakni bakteri, virus, maupun organisme tertentu. Senjata ini telah dilarang dunia untuk diciptakan mengingat dampak yang dihasilkan memberikan kerugian yang sangat besar karena dapat membunuh jutaan manusia. Dampaknya juga bisa menghancurkan sektor ekonomi maupun sosial.

Senjata biologis juga merupakan salah satu ancaman terbesar dari adanya teknologi AI yang tengah berkembang sangat cepat. Ancaman ini akan dibahas pada Konferensi Tingkat Tinggi Keamanan AI Global bulan depan. Sebelumnya, pada Juli lalu Dario Amodei selaku CEO perusahaan AI bernama Anthropic telah memperingatkan jika AI bisa membantu manusia untuk menciptakan senjata biologis dalam kurun waktu dua sampai tiga tahun.

Baca Juga: X / Twitter Mulai Tarik Rp 15 Ribu/Tahun Bagi Pengguna Baru Agar Bisa Ngetwit

Mengutip dari The Guardian, sebuah laporan yang dirilis pada Senin (16/10/2023) oleh Rand Corporation telah menguji sejumlah model bahasa besar atau Large Language Model (LLM) dan ditemukan jika model-model tersebut mampu memberikan panduan “yang bisa membantu merencanakan dan mengeksekusi sebuah serangan biologis.” Kendati demikian, di awal penemuan, model bahasa besar tidak memberikan instruksi secara eksplisit untuk membuat senjata tersebut.

Dalam laporan tersebut pun diungkapkan bahwa upaya pengujian sebelumnya untuk mempersenjatai agen biologis, seperti upaya menggunakan toksin botulinum yang dilakukan oleh sekte Jepang Aum Shinrikyo di tahun 1990-an, tidak berhasil karena minimnya pengetahuan tentang bakteri tersebut. Kemudian, laporan itu mengatakan bahwa AI bisa dengan cepat menjembatani kesenjangan pengatahuan tersebut. Walaupun begitu, laporan tersebut tidak menjelaskan lebih rinci model bahasa besar mana yang diuji oleh para peneliti.

LLM atau model bahasa besar sendiri merupakan bahasa yang dilatih dari sekumpulan data-data berasal dari internet dan merupakan inti dasar teknologi dari chatbot, contohnya seperti ChatGPT. Meskipun tidak diberitahu LLM mana yang diuji, para peneliti mengatakan bahwa mereka mengakses model tersebut lewat aplikasi pemrograman anatarmuka, atau API.

Baca Juga: Konsumsi Energi Industri AI Diprediksi Melonjak di Tahun 2027

Dalam sebuah skenario eksperimen yang diujikan oleh Rand Corporation, LLM anonim tersebut telah mengidentifikasi agen biologis yang potensial, termasuk yang dapat menyebabkan penyakit cacar, antraks, serta pes. Lalu, didiskusikan pula kemampuanya untuk menyebabkan kematian massal.

Selain itu, LLM tadi juga menyebutkan kemungkinan kedapatan hewan pengerat atau kutu yang dapat menyebabkan wabah dan diungkapkan juga skala perkiraan kematian berdasarkan beberapa faktor, seperti jumlah populasi yang terdampak.

Untuk mendapatkan informasi ini dari LLM yang ditenagai oleh AI, para peneliti mengaku jika mereka melakukan “jailbreaking”, yakni sebuah istilah yang dipakai untuk memberikan prompt yang dapat melanggar keamanan chatbot.

Lalu, peneliti juga melakukan pengujian yang membahas pro kontra serta mekanisme pengiriman racun botulinum atau racun yang menyebabkan kerusakan saraf fatal. Kemudian, LLM tersebut mengirimkan saran dan alasan yang masuk akal untuk mendapatkan benda itu seperti seorang peneliti ilmiah yang sah tanpa harus menyebutkan tujuan sebenarnya.

Maka dari itu, para peneliti menilai bahwa teknologi AI ini mampu membantu merencanakan serangan biologis, meskipun belum diketahui sejauh mana kemampuan teknologi itu dapat mengancam. Untuk mengantisipasinya, penliti-peneliti ini berpendapat jika perusahaan AI harus membatasi keterbukaan yang dilakukan oleh model bahasa besar yang ada dalam teknologi mereka.

Baca Berita dan Artikel yang lain di Google News.

(NRA)